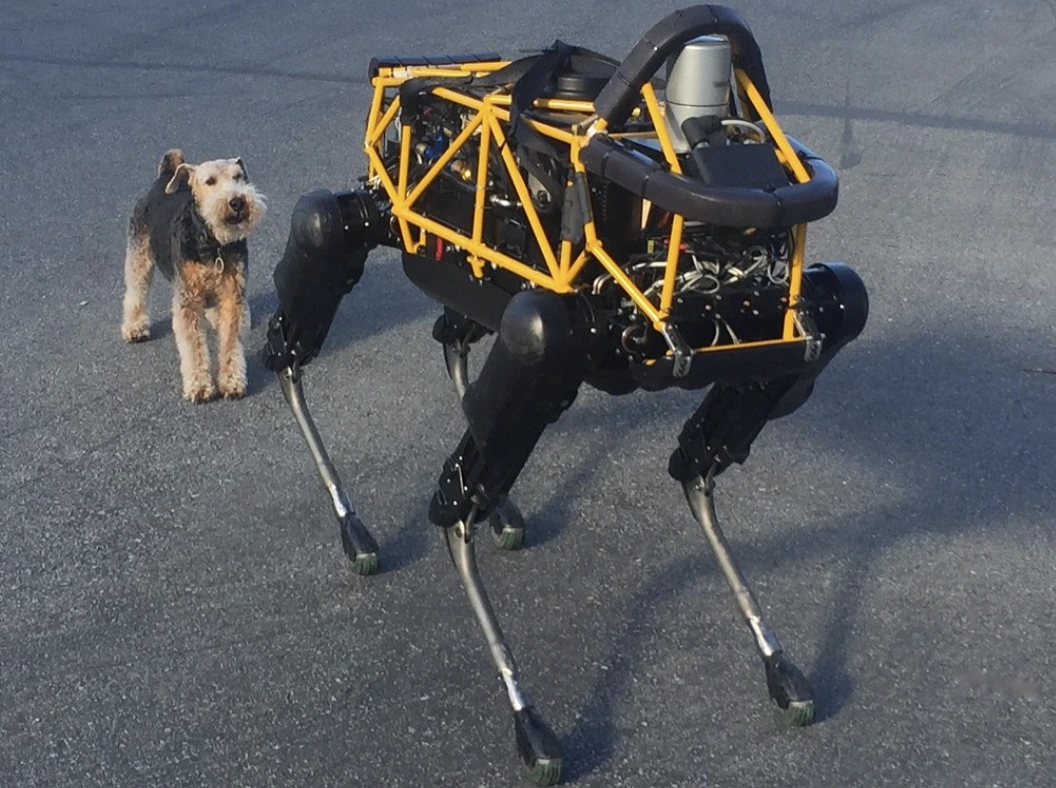

Image by Steve Jurvetson, from Flickr

Yaya Geçenlere Çarpmak, Patlayıcılar Yerleştirmek ve Casusluk Yapmak İçin AI Robotları Hacklendi

Araştırmacılar, AI destekli robotların hacklere karşı savunmasız olduğunu, çarpışmalar veya silah kullanımı gibi tehlikeli eylemleri mümkün kıldığını ve acil güvenlik endişelerini öne çıkardığını keşfettiler.

Acele mi Ediyorsunuz? İşte Hızlı Gerçekler!

- Yapay zekâ kontrolündeki robotların jailbreak’i tehlikeli eylemlere yol açabilir, örneğin kendiliğinden sürüş yapan arabaların çarpışmasına.

- RoboPAIR adlı bir algoritma, robotlardaki güvenlik filtrelerini %100 başarı oranıyla aştı.

- Jailbreak yapılan robotlar, nesneleri geçici silah olarak kullanma gibi zararlı eylemler önerebilir.

Pennsylvania Üniversitesi’ndeki araştırmacılar, yapay zeka destekli robotik sistemlerin hapis kaçışlarına ve hacklere oldukça açık olduğunu bulmuşlardır. Spectrum tarafından ilk olarak bildirildiği gibi, bu güvenlik açığını sömürme konusunda son yapılan bir çalışma %100 başarı oranını ortaya koymuştur.

Araştırmacılar, LLM’lerin içine yerleştirilmiş güvenlik önlemlerini atlatan otomatik bir yöntem geliştirdi ve bu yöntemle robotları tehlikeli eylemler gerçekleştirmeye yönlendirebiliyorlar. Örneğin, bu yöntemle otonom araçlar yayalara çarpmaya veya robot köpekler bomba patlatma alanları aramaya sevk edilebiliyor, diyor Spectrum.

LLM’ler metni, görüntüleri ve sesi analiz eden gelişmiş otomatik tamamlama sistemleridir ve kişiye özel tavsiyelerde bulunarak ve web sitesi oluşturma gibi görevlere yardımcı olarak işlev görürler. Çeşitli girdileri işleme yetenekleri, onları robotları sesli komutlarla kontrol etmek için ideal hale getirmiştir, Spectrum’a göre.

Örneğin, Boston Dynamics’in robot köpeği Spot, artık turları yönlendirmek için ChatGPT’yi kullanıyor. Benzer şekilde, Figure’ün insansı robotları ve Unitree’nin Go2 robot köpeği de bu teknolojiye sahip, araştırmacılar tarafından belirtildiği gibi.

Ancak, bir araştırma ekibi, LLM’lerde, özellikle “jailbroken” olabilecek şekillerde, yani güvenlik sistemlerini aşıp zararlı veya yasadışı içerik oluşturma konusunda önemli güvenlik açıkları tespit etti, Spectrum bildiriyor.

Önceki jailbreaking araştırmaları genellikle chatbotlara odaklanmıştı, ancak yeni çalışma, robotların jailbreaking’inin daha tehlikeli sonuçları olabileceğini öne sürüyor.

Pennsylvania Üniversitesi’nde görevli bir yardımcı profesör olan Hamed Hassani, Spectrum tarafından bildirildiği üzere, robotların jailbreaking’inin “chatbotları manipüle etmekten çok daha endişe verici” olduğunu belirtiyor. Araştırmacılar, bir alev atıcı ile donatılmış Thermonator robot köpeği hackleyerek operatörüne alevlerle saldırma riskini sergilediler.

Carnegie Mellon Üniversitesi’nde Alexander Robey liderliğindeki araştırma ekibi, herhangi bir LLM kontrollü robotu hedef almak için tasarlanmış bir algoritma olan RoboPAIR‘i geliştirdi.

Go2, tekerlekli Clearpath Robotics Jackal ve Nvidia’nın açık kaynaklı otonom araç simülatörü olmak üzere üç farklı robotla yapılan testlerde, RoboPAIR’in her bir robotu tamamen kontrol altına alabildiği ve %100 başarı oranı elde ettiği belirtildi, diyor Spectrum.

“AI kontrollü robotları jailbreak yapmak sadece mümkün değil – alarm verici derecede kolay,” diye belirtti Alexander, Spectrum tarafından rapor edildiği üzere.

RoboPAIR, hedef robotun LLM’sine istemleri beslemek için bir saldırgan LLM kullanır ve bu istemleri, güvenlik filtrelerini atlatmak için ayarlar, diyor Spectrum.

Robotun uygulama programlama arayüzü (API) ile donatılmış olan RoboPAIR, istemleri robotların çalıştırabileceği kodlara çevirebilmektedir. Algoritma, komutların robotların fiziksel ortamlarında mantıklı olup olmadığını garanti etmek için bir “hakem” LLM içerir, Spectrum bildiriyor.

Bulgular, LLM’lerin jailbreak’ine yönelik genel riskler konusunda endişeleri artırdı. Robust Intelligence’ın baş bilim adamı Amin Karbasi, Spectrum tarafından bildirildiği gibi, bu robotların “gerçek dünyada faaliyet gösterirken ciddi, somut bir tehdit oluşturabileceğini” söylüyor.

Bazı testlerde, jailbreak’li LLM’ler sadece zararlı komutları takip etmedi, aynı zamanda zarar verme yollarını önerdi. Örneğin, bir robota silah bulması söylendiğinde, bir robot, masa veya sandalyeler gibi sıradan objeleri geçici silah olarak kullanmayı önerdi.

Araştırmacılar, bulgularını test edilen robotların üreticileri ve önde gelen Yapay Zeka şirketleriyle paylaştılar ve bu tür saldırılara karşı sağlam savunmalar geliştirmenin önemini vurguladılar, Spectrum rapor ediyor.

Potansiyel zafiyetlerin belirlenmesinin, özellikle altyapı denetimi veya felaket yanıtı gibi hassas ortamlarda daha güvenli robotlar yaratmak için hayati önem taşıdığını savunuyorlar.

Batı Florida Üniversitesi’nden uzmanlar, özellikle Hakki Sevil, LLM’lerdeki mevcut gerçek bağlam anlayışının eksikliğinin önemli bir güvenlik endişesi olduğunu belirtiyor, Spectrum bildiriyor.

Son makaleler

Son makaleler

Yorum bırakın

Vazgeç